Neutrinos: la Luz Invisible

Primer paso para descubrir por qué existe la materia

Colocada la primera piedra de un gran experimento que puede cambiar nuestro conocimiento del Universo

Más de 1.000 científicos e ingenieros de 30 países, entre ellos España, participan en un gran experimento internacional que puede cambiar nuestro conocimiento del Universo. Tardará una década en construirse, pero la primera piedra de su infraestructura acaba de colocarse en USA. El experimento estudiará las propiedades de las misteriosas partículas llamadas neutrinos, que pueden desvelarnos cómo funciona el Universo y por qué existe la materia.

Los científicos, en el inicio de las obras. Foto: Reidar Hahn, Fermilab.

Con una ceremonia celebrada el viernes pasado en el Laboratorio Subterráneo de Sanford (SURF) en Lead, Dakota del Sur, Estados Unidos, un grupo de dirigentes políticos, científicos e ingenieros de todo el mundo marcó el inicio de la construcción de un gran experimento internacional que podría cambiar nuestro conocimiento del Universo.

Se trata de la instalación Long-Baseline Neutrino Facility (LBNF), que albergará el experimento internacional DUNE(Deep Underground Neutrino Experiment), que será construido y operado por más de 1.000 científicos e ingenieros de 30 países, entre ellos España.

Cuando esté finalizado, LBNF/DUNE será el mayor experimento construido en Estados Unidos para estudiar las propiedades de las misteriosas partículas llamadas neutrinos. Desvelar los misterios de estas partículas podría ayudarnos a explicar mejor cómo funciona el Universo y por qué existe la materia.

Instituciones de decenas de países contribuirán a la construcción de los componentes de DUNE. Este experimento atraerá a estudiantes y jóvenes investigadores de todo el mundo, formando a la próxima generación de científicos que liderará este campo de investigación.

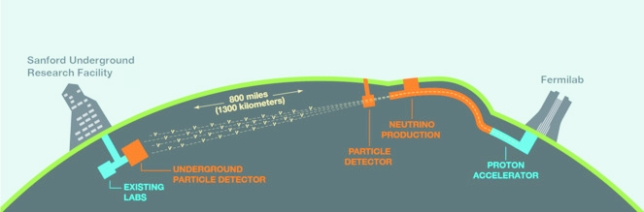

El laboratorio Fermilab, situado a las afueras de Chicago, producirá un haz de neutrinos y lo enviará a 1.300 kilómetros a través de la Tierra hasta SURF, donde se construirán cuatro grandes detectores de una altura de 4 pisos y 70.000 toneladas de argón líquido bajo la superficie para atrapar estos neutrinos.

El misterio de los neutrinos

Los científicos estudiarán las interacciones de los neutrinos en los detectores para entender mejor los cambios que sufren estas partículas cuando viajan de un punto a otro en un abrir y cerrar de ojos.

Desde su descubrimiento hace más de 60 años, los neutrinos han demostrado ser la partícula subatómica más sorprendente, y el que oscile entre tres estados diferentes es una de sus mayores sorpresas. Este hallazgo comenzó con un experimento de neutrinos solares dirigido por Ray Davis en los años 60, y llevado a cabo en la misma mina subterránea que ahora albergará a LBNF/DUNE. Davis obtuvo el Premio Nobel de Física en 2002 por este experimento.

Los científicos de DUNE también buscarán diferencias en el comportamiento entre los neutrinos y sus réplicas de antimateria, los antineutrinos, lo que nos podría dar pistas sobre por qué vivimos en un Universo dominado por la materia. DUNE también observará los neutrinos producidos en las explosiones estelares, lo que revelaría la formación de estrellas de neutrones y agujeros negros. También investigará si los protones viven para siempre o se desintegran eventualmente en otras partículas, acercándonos a la realización del sueño de Einstein: la Teoría de la Gran Unificación.

Pero antes se tiene que construir la instalación, algo que ocurrirá en la próxima década. Los operarios comenzarán la construcción excavando más de 870.000 toneladas de rocas para crear las enormes cavernas subterráneas del detector DUNE. Mientras, se construyen grandes prototipos de DUNE en el laboratorio europeo de física de partículas (CERN), uno de los mayores socios del proyecto, y la tecnología desarrollada para estas versiones más pequeñas se probará y ampliará cuando se fabriquen los grandes detectores de DUNE.

Esta instalación está financiada por la Oficina de Ciencia del Departamento de Energía de los Estados Unidos, en colaboración con el CERN y otros socios de 30 países. Los científicos que participan en DUNE proceden de instituciones científicas de Armenia, Brasil, Bulgaria, Canadá, Chile, China, Colombia, Corea del Sur, Estados Unidos, España, Finlandia, Francia, Grecia, Holanda, India, Irán, Italia, Japón, Madagascar, México, Perú, Polonia, República Checa, Rumanía, Rusia, Suecia, Suiza, Turquía, Ucrania y Reino Unido.

Fermilab, situado a las afueras de Chicago, producirá un haz de neutrinos y lo enviará a 1.300 kilómetros a través de la Tierra hasta SURF, en Dakota del Sur. Imagen: Fermilab.

Amplia participación española

Cuatro centros de investigación españoles forman parte de la colaboración científica del experimento DUNE: el Centro de Investigaciones Energéticas Medioambientales y Tecnológicas (CIEMAT), el Instituto de Física Teórica (IFT, UAM-CSIC), el Instituto de Física de Altas Energías (IFAE) y el Instituto de Física Corpuscular (IFIC, CSIC-UV).

Sus contribuciones abarcan tanto el diseño y la construcción del experimento, en particular de los detectores que se instalarán en el Laboratorio Subterráneo de Sanford, como los estudios para optimizar la explotación científica del experimento.

Un paso previo y crucial a la construcción de estos detectores en SURF es fabricar prototipos para probar la tecnología. Esta tarea, donde las instituciones españolas también participan, se lleva a cabo en el CERN con la construcción de dos grandes prototipos, llamados ProtoDUNE single phase (ProtoDUNE-SP) y ProtoDUNE dual phase (ProtoDUNE-DP), que se probarán con haces de partículas cargadas a partir de 2018.

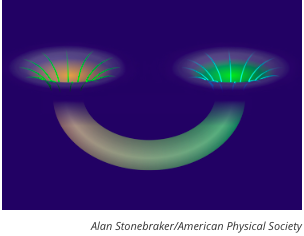

Los grupos de investigación en neutrinos del CIEMAT de Madrid y del IFAE de Barcelona son responsables del sistema de detección de luz de ProtoDUNE-DP, formado por 36 fotomultiplicadores que detectan y amplifican la luz producida por las interacciones de partículas en el detector y la convierten en una señal eléctrica.

El CIEMAT lleva a cabo la caracterización de estos fotomultiplicadores para comprender su respuesta ante distintas señales de luz. Además, estos requieren un revestimiento especial que permite cambiar la luz invisible producida en el argón a una longitud de onda visible por los detectores, tarea que realiza el IFAE. El CIEMAT coordina el grupo de trabajo de DUNE dedicado a la detección de neutrinos procedentes de supernovas, donde la señal de luz producida por los fotomultiplicadores es vital al indicar el comienzo de los sucesos originados por la explosión de una supernova.

Desintegración del protón

Por otro lado, el grupo experimental de física de neutrinos del IFIC (CSIC-Universidad de Valencia) lidera el sistema de instrumentación criogénica del detector ProtoDUNE-SP, así como su sistema de monitorización y control de parámetros fundamentales como temperatura, presión, nivel y pureza del argón. Además, el grupo del IFIC coordina el grupo de trabajo de la colaboración DUNE sobre la desintegración del protón, estudiando la sensibilidad del experimento para medir este fenómeno que aún no ha sido detectado. Por otra parte, los científicos e ingenieros del IFIC trabajan también en el desarrollo de herramientas para el análisis de datos de ProtoDUNE-SP y DUNE.

Por su parte, el IFT (Universidad Autónoma de Madrid-CSIC), con contribuciones de miembros del IFIC, lidera la realización de simulaciones sobre las capacidades de DUNE para determinar parámetros aún desconocidos, como el que codifica la posible diferencia de comportamiento entre neutrinos y antineutrinos, clave para entender el exceso de materia sobre antimateria en el Universo. DUNE observará haces de neutrinos con una intensidad y precisión sin precedentes, lo que permitirá explorar respuestas a preguntas fundamentales de la física actual.

Por ejemplo, comprobando la existencia de neutrinos más pesados pero con interacciones aún más débiles que los conocidos hasta ahora, o de nuevas interacciones de los neutrinos. DUNE también podría desentrañar la naturaleza de las misteriosas partículas que forman la materia oscura del Universo, que podrían producirse junto con los neutrinos en el haz producido en Fermilab y ser descubiertas en el detector más cercano. Estas simulaciones son fundamentales en esta etapa del experimento para identificar las posibles modificaciones en el diseño que optimizarían la sensibilidad del mismo

Fuente: Tendencias21